شبکه های عصبی تولید کننده ی تصویر در حال حاضر همه جا هستند. آن ها چه خطراتی برای حفظ حریم خصوصی دارند؟

شبکه های (عصبی) شما در حال نشت هستندمحققان دانشگاه های ایالات متحده و سوئیس با همکاری گوگل و DeepMind مقاله ای منتشر کرده اند که نشان می دهد چگونه داده ها می توانند از سیستم های تولید تصویر که از الگوریتم های یادگیری ماشینی DALL-E ،Imagen یا Stable Diffusion استفاده می کنند، نشت کنند. همه آن ها در سمت کاربر یکسان عمل می کنند: شما یک عبارت متنی خاص را تایپ می کنید - به عنوان مثال، "صندلی راحتی به شکل آووکادو" - و در عوض یک تصویر تولید شده دریافت می کنید.

تصویر تولید شده توسط شبکه عصبی Dall-E

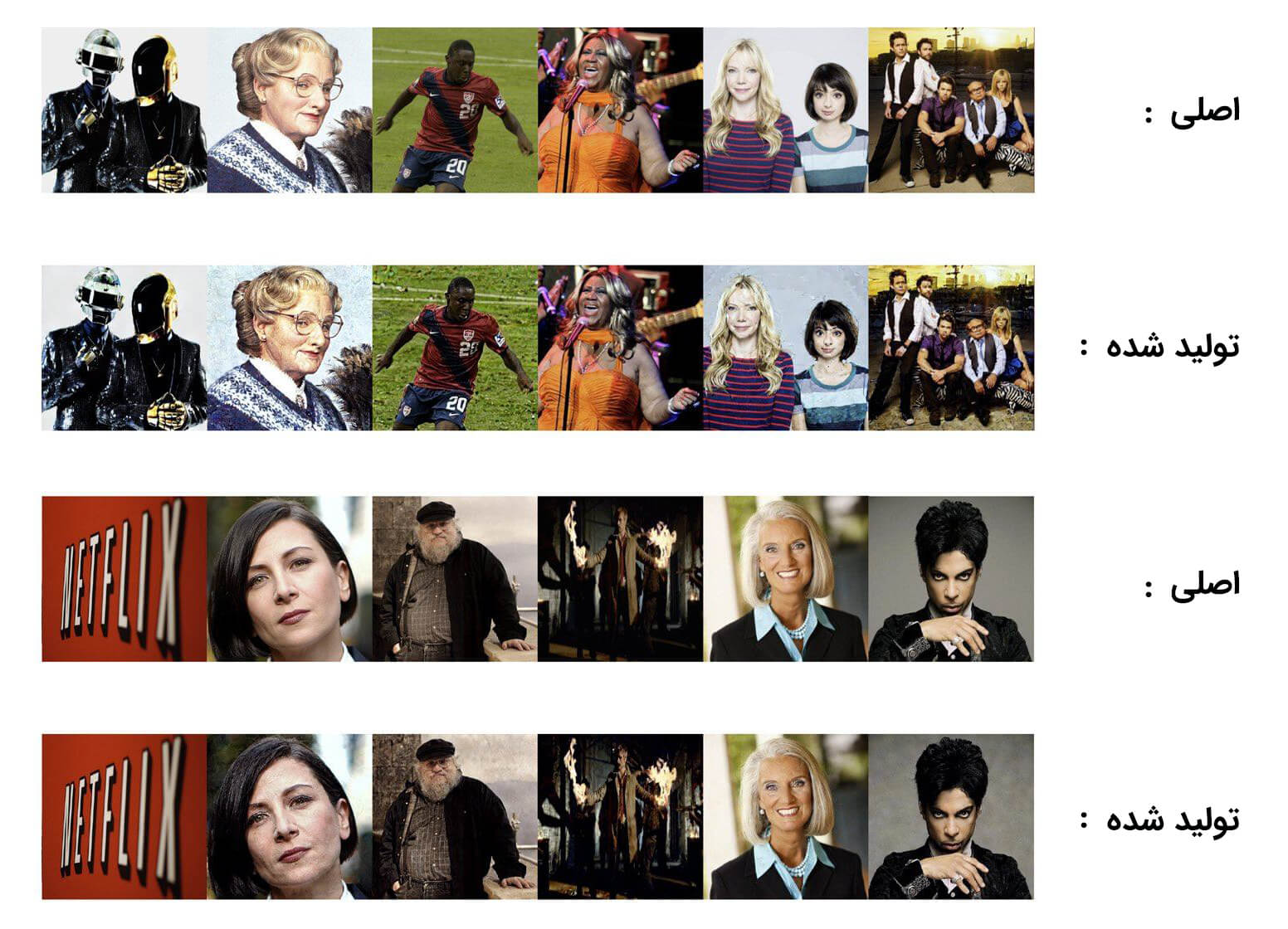

همه این سیستم ها بر روی تعداد زیادی (ده ها یا صدها هزار) تصویر با توضیحات از پیش آماده شده، آموزش دیده اند. ایده پشت چنین شبکه های عصبی این است که آن ها می توانند با مصرف حجم زیادی از داده های آموزشی، تصاویر جدید و منحصر به فرد ایجاد کنند. با این حال، نکته اصلی مطالعه جدید این است که این تصاویر همیشه آنقدرها هم منحصر به فرد نیستند. در برخی موارد ممکن است شبکه عصبی را مجبور کنیم تا دقیقا یک تصویر اصلی را که قبلا برای آموزش استفاده شده بود، باز تولید کند. و این بدان معناست که شبکه های عصبی می توانند ناخواسته اطلاعات خصوصی را افشا کنند.

تصویر تولید شده توسط شبکه عصبی Stable Diffusion (راست) و تصویر اصلی از مجموعه آموزشی (سمت چپ).

داده های بیشتر برای "خدای داده"

خروجی یک سیستم یادگیری ماشینی (Machine-Learning - ML) در پاسخ به یک پرس و جو می تواند برای افراد غیرمتخصص جادویی به نظر برسد: "وای - مثل یک ربات دانا!" اما واقعا جادویی وجود ندارد…

همه شبکه های عصبی کم و بیش به یک شکل کار می کنند: الگوریتمی ایجاد می شود و بر روی یک مجموعه داده آموزش می بیند - به عنوان مثال مجموعه ای از عکس های گربه و سگ - با توصیف اینکه هر تصویر دقیقا چه چیزی را نشان می دهد. پس از مرحله ی آموزش، به الگوریتم یک تصویر جدید نشان داده و از او خواسته می شود بفهمد گربه است یا سگ. از این شروع فروتنانه، توسعه دهندگان چنین سیستم هایی به سمت سناریوی پیچیده تری حرکت کردند: الگوریتم که بر روی تصاویر گربه ها آموزش داده شده در صورت تقاضا، تصویری از یک گربه خانگی ایجاد می کند که هرگز وجود نداشته است. چنین آزمایش هایی نه تنها با تصاویر، بلکه با متن، ویدیو و حتی صدا نیز انجام می شود (مانند دیپ فیک، که به وسیله آن ویدیوهای سیاستمداران یا افراد مشهور به صورت دیجیتالی تغییر یافته است و به نظر می رسد چیزهایی می گویند که در واقعیت نگفته اند).

برای همه شبکه های عصبی نقطه شروع، مجموعه ای از داده های آموزشی است: شبکه های عصبی نمی توانند موجودیت های جدیدی را از هیچ اختراع کنند. برای ایجاد تصویری از یک گربه، الگوریتم باید هزاران عکس یا نقاشی واقعی از این حیوانات را مطالعه کند. دلایل زیادی برای محرمانه نگه داشتن این مجموعه داده ها وجود دارد. برخی از آن ها در حوزه عمومی هستند؛ سایر مجموعه داده ها متعلق به شرکت توسعه دهنده هستند که زمان و تلاش قابل توجهی برای ایجاد آن ها به امید دستیابی به یک مزیت رقابتی سرمایه گذاری کرده است. برخی دیگر، اطلاعات حساس را تشکیل می دهند. به عنوان مثال، آزمایش هایی برای استفاده از شبکه های عصبی جهت تشخیص بیماری ها بر اساس اشعه ایکس و سایر اسکن های پزشکی در حال انجام است. این بدان معنی است که داده های آموزشی، حاوی داده های واقعی سلامت افراد است که به دلایل واضح نباید به دست افراد نادرست بیفتد.

منتشر کنیداگرچه الگوریتم های یادگیری ماشینی برای افراد غیر متخصص یکسان به نظر می رسند، اما در واقع متفاوتند. محققان در مقاله خود، توجه ویژه ای به مدل های انتشار یادگیری ماشینی دارند. آن ها به این صورت کار می کنند: داده های آموزشی (باز هم تصاویر افراد، ماشین ها، خانه ها و ...) با اضافه کردن نویز تغییر می کنند. و سپس شبکه عصبی برای بازگرداندن چنین تصاویری به حالت اولیه آموزش داده می شود. این روش امکان تولید تصاویر با کیفیت مناسب را فراهم می کند، اما اشکال آن ها در مقایسه با الگوریتم ها در شبکه های مولد تخاصمی (Generative Adversarial Network - GAN)1 تمایل بیشتر، به نشت داده است.

داده های اصلی را می توان حداقل به سه روش مختلف از آن ها استخراج کرد: ابتدا با استفاده از پرس و جوهای خاص، می توانید شبکه عصبی را مجبور به تولید خروجی کنید - نه چیزی منحصر به فرد که بر اساس هزاران تصویر ایجاد شده باشد - بلکه یک منبع تصویر خاص. دوم، تصویر اصلی می تواند بازسازی شود حتی اگر تنها بخشی از آن در دسترس باشد. سوم، به سادگی می توان تعیین کرد که آیا یک تصویر خاص در داده های آموزشی وجود دارد یا خیر.

اغلب، شبکه های عصبی تنبل هستند و به جای یک تصویر جدید، چیزی از مجموعه آموزشی تولید می کنند. (البته اگر مجموعه دارای چندین نسخه تکراری از همان تصویر باشد.) علاوه بر مثال بالا با عکس آن گراهام لوتز، این مطالعه نتایج مشابه دیگری نیز ارائه می دهد:

ردیف های فرد: تصاویر اصلی. ردیف های زوج: تصاویر تولید شده توسط Stable Diffusion v1.4

اگر تصویری بیش از صد بار در مجموعه آموزشی تکرار شود، احتمال بسیار بالایی برای نشت آن به شکل نسخه اصلی وجود دارد. با این حال، محققان راه هایی را برای بازیابی تصاویر آموزشی که فقط یک بار در مجموعه اصلی ظاهر شده بودند، نشان دادند. این روش کارایی بسیار کمتری دارد: از پانصد تصویر آزمایش شده، الگوریتم به طور تصادفی تنها سه مورد از آن ها را بازسازی کرد. هنری ترین روش حمله به یک شبکه عصبی شامل بازسازی یک تصویر منبع با استفاده از تنها بخشی از آن به عنوان ورودی است.

پس از حذف بخشی از تصویر، محققان از شبکه عصبی خواستند که تصویر را تکمیل کند. با انجام این کار می توان تعیین کرد که آیا یک تصویر خاص در مجموعه آموزشی وجود دارد یا خیر. اگر اینطور بود، الگوریتم یادگیری ماشینی یک کپی تقریبا دقیق از عکس یا طراحی اصلی ایجاد می کرد.

در این مرحله، بیایید توجه خود را به موضوع شبکه های عصبی و حق چاپ (کپی رایت) معطوف کنیم.

چه کسی از چه کسی سرقت کرد؟در ژانویه 2023، سه هنرمند از سازندگان سرویس های تولید تصویر که از الگوریتم های یادگیری ماشینی استفاده می کردند شکایت کردند. هنرمندان به طور موجه ادعا کردند که توسعه دهندگان، شبکه های عصبی را بر روی تصاویر جمع آوری شده آنلاین بدون رعایت کپی رایت آموزش داده اند. یک شبکه عصبی در واقع می تواند سبک یک هنرمند خاص را کپی کند و در نتیجه به کسب درآمد او آسیب برساند. این مقاله اشاره می کند که در برخی موارد الگوریتم ها می توانند به دلایل مختلف، دست به سرقت علمی بزنند. زیرا نقشه ها، عکس ها و تصاویری که تولید می کنند تقریبا مشابه کار افراد واقعی است.

این مطالعه توصیه هایی را برای تقویت حریم خصوصی مجموعه آموزشی اصلی ارائه می دهد:

- از شر نسخه های تکراری خلاص شوید.

- تصاویر آموزشی را مجددا پردازش کنید، به عنوان مثال با اضافه کردن نویز یا تغییر روشنایی؛ با این کار احتمال نشت داده ها کمتر می شود.

- الگوریتم را با تصاویر آموزشی ویژه آزمایش کنید؛ سپس بررسی کنید که به طور ناخواسته، آن ها را عینا باز تولید نکرده باشد.

مرحله بعدی چیست؟

اخلاق و قانونمندی هنر مولد2، قطعا بحث جالبی را ایجاد می کند - بحثی که در آن باید بین هنرمندان و توسعه دهندگان فناوری به دنبال تعادل بود. از طرفی کپی رایت باید رعایت شود. از سوی دیگر این سوال وجود دارد، آیا هنر کامپیوتر تا این اندازه با انسان متفاوت است؟ در هر دو مورد، سازندگان از آثار همکاران و رقبا الهام می گیرند.

اما بیایید در مورد امنیت صحبت کنیم. این مقاله مجموعه ای از حقایق را درباره تنها یک مدل یادگیری ماشینی ارائه می دهد. با تعمیم این مفهوم به همه الگوریتم های مشابه، به موقعیت جالبی می رسیم. تصور سناریویی که در آن دستیار هوشمند اپراتور تلفن همراه، در پاسخ به درخواست کاربر اطلاعات حساس شرکت را ارائه می دهد سخت نیست: گذشته از اینها، این در داده های آموزشی بوده است. یا به عنوان مثال، یک پرس و جوی حیله گرانه، شبکه عصبی عمومی را فریب می دهد تا یک کپی از پاسپورت شخص دیگری را تولید کند. محققان تاکید می کنند که چنین مشکلاتی فعلا به صورت تئوری باقی می مانند.

اما مشکلات دیگری در حال حاضر وجود دارد. همانطور که صحبت می کنیم، شبکه عصبی تولید متن ChatGPT برای نوشتن کدهای مخرب واقعی استفاده می شود که (گاهی) کار می کند. و GitHub Copilot به برنامه نویسان کمک می کند تا با استفاده از مقدار زیادی نرم افزار منبع باز به عنوان ورودی کد بنویسند. و این ابزار به کپی رایت و حریم خصوصی نویسندگانی که کد آن ها در مجموعه گسترده داده های آموزشی قرار گرفته است، احترام نمی گذارد. با تکامل شبکه های عصبی، حملات به آن ها نیز افزایش می یابند - با عواقبی که هنوز هیچ کس کاملا آن را درک نکرده است.

1- یک شبکه مولد تخاصمی (GAN) یک مدل یادگیری ماشینی است که در آن دو شبکه عصبی با استفاده از روش های یادگیری عمیق برای دقیق تر شدن در پیش بینی های خود با یکدیگر رقابت می کنند.

2- هنر مولد به هنری می گویند که به طور کامل یا جزئی با استفاده از یک سیستم خودمختار ساخته شده است، هنر مولد ممکن است اشکال مختلفی از جمله موسیقی، ادبیات و تصاویر کامپیوتری داشته باشد.